最近,新华网发布的一则反诈短视频在社交平台引发关注。这条旨在揭露AI换脸、变声骗局的宣传片发布后,有网友说“被吓到了”,还有评价说“像恐怖片”。这是为什么呢?

原来,很多网友没有想到,AI换脸、换声能那么“真”:短视频以温馨的母女视频通话情节开始。母亲正在家里煲汤等女儿回家,女儿撒娇说航班延误又掉了一部手机,央求母亲转账应急。就在母亲用网银转账时,门铃响起,母亲以为没带钥匙的父亲回家,暂停转账去开门。谁知,门外站着女儿。此时,视频电话里的“女儿”还在一口一个“妈,你是世界上最好的妈”。

反诈视频中,真人与AI变脸“面对面”(图源:新华网视频截屏)。

反诈视频中,真人与AI变脸“面对面”(图源:新华网视频截屏)。

所以,宣传片的主题是告诉网友,AI可以模拟人脸和人声,视频里看到和听到的都不一定是真实的,要警惕新型诈骗电话。

不少网友一边评价“太吓人”,一边询问:AI技术真的进化到可以如此逼真的“换脸换声”了吗?答案是肯定的。

只要3步,“换脸”成功

“AI换脸、换声并且用视频的形式误导公众,已经不算技术难题。”人工智能企业合合信息的技术人员展示了3步换脸:第一步,对着演示屏幕的摄像头,根据提示上下左右转头,录入真人信息;第二步,选择两张想要的新脸照片;第三步,演示屏幕显示,这名技术人员已经拥有了两张全新的“脸”,新脸还能跟随身体的主人做出各种头部动作与面部表情。对普通人而言,压根看不出显示屏幕上的“人”是AI生成的。

左:真人信息录入;中:选择要变的“脸”;右:变脸完成(作者摄)。

左:真人信息录入;中:选择要变的“脸”;右:变脸完成(作者摄)。

技术人员表示,AI换声也很方便,很多消费级的软件已经提供这些服务。只要向相关软件提供一定的声纹资源,软件很快就能模拟目标声音,实现以假乱真的效果。

所以,千万不要以为反诈短视频中的“换脸变声诈骗”是演绎。随着AI技术的发展,换脸、变声已经不再困难。而且,有不法分子已经用换脸、换声等骗取钱财。

前不久,湖北警方就披露了一起“变声”诈骗案件:被害人刘女士接到“孙子”电话说,不当心伤害到别的孩子,“私了”要2万元钱,怕被母亲责骂,“请奶奶救救我,不要告诉妈妈”。刘女士觉得电话那头就是“孙子”的声音,决定凑钱帮孙子。接着,孙子说有人来找刘女士拿钱,在交接钱款时,刘女士又听到了电话里“孙子”的声音,确认无误后,把钱款给了对方。过了几天,刘女士遇到孙子问起这件事,才发现上当受骗,然后报警。

警方经过调查,抓获了犯罪嫌疑人,并根据被害人提供的线索分析认为,犯罪嫌疑人可能是通过多次拨打座机电话,逐步收集了她孙子的声纹信息,基于它们用AI技术造假,实施诈骗。

识破AI换脸和变声,这些诀窍有用

那么,如何预防AI换脸、变声诈骗呢?

最简单的是使用只有当事人才知道的“暗语”或者方言。当视频通话等涉及转账等话题,当事人要先想办法求证对方是本人还是AI造假。比如,可以询问对当事双方都有特别意义的纪念日、改用方言交流等。此时,AI造假极可能露馅。

同时,个人应注意保护隐私信息。高清的面部信息、声纹信息等,都属于隐私信息,它们都是被模仿的基础。所以,在社交平台上晒视频、晒照片、晒声音等行为,其实存在一定的被模仿风险。

此外,通讯硬件、软件等服务供应方,则要有“用魔法打败魔法”的防范思路。

技术人员表示,在生活中,不法分子不仅用AI换脸、变声诈骗,还会用换脸、变声“撞库”,盗取他人钱财。比如,不法分子获得目标对象的脸部图像后,试图通过“人脸识别”的方式,登录目标对象的各种账户,盗取数据、转移财产等。

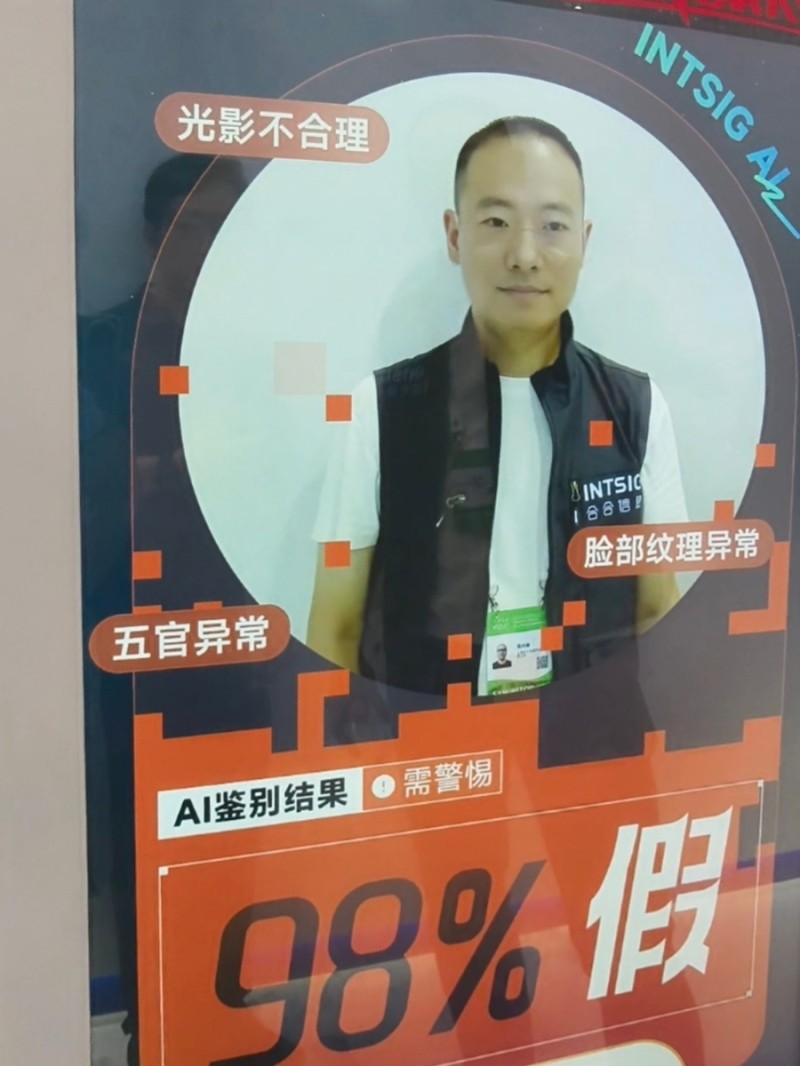

AI造假后“撞库”的后果往往比AI造假后诈骗更大,所以需要从源头加以识别、拦截。此时,AI也可以成为帮手:AI通过对光影、脸部纹理、动态五官是否合理等细节的监控和计算,得出鉴定结果。

用AI识别AI造假(作者摄)。

用AI识别AI造假(作者摄)。

“因为AI捕捉和比对的精细度远远超过人眼,所以能识别人眼发现不了的造假视频。”技术人员表示,如果在涉及人脸识别、声纹识别的服务中嵌入以上技术,那么能极大限度地防范AI造假。